前回はナイーブベイズで分類モデルを作成しました。

複数のナイーブベイズのモデルを試しましたが、CategoricalNBが0.76315でナイーブベイズのモデルの中では一番精度がよかったです。

(その4-6) タイタニックの乗客の生存有無をナイーブベイズで予測してみた

前回、ロジスティック回帰CVで76.7%の精度でした。今回はナイーブベイズを使って予測してみようと思います。The sklearn.naive_bayes module implements Naive Bayes algorithms. ...

暫定1位はロジスティック回帰CVで作成してモデルで、Kaggleの精度は0.76794です。

評価指標

タイタニックのデータセットは生存有無を正確に予測できた乗客の割合(Accuracy)を評価指標としています。

モデル作成前の事前準備

分析用データの準備

事前に欠損値処理や特徴量エンジニアリングを実施してデータをエクスポートしています。

本記事と同じ結果にするためには事前に下記記事を確認してデータを用意してください。

タイタニックのモデリング用データの作成まとめ

(その3-5) タイタニックのデータセットの変数選択にてモデリング用のデータを作成し、エクスポートするコードを記載していましたが分かりずらかったので簡略しまとめました。上から順に流していけばtitanic_train.csvとtitanic...

学習データと評価データの読み込み

import pandas as pd

import numpy as np

# タイタニックデータセットの学習用データと評価用データの読み込み

df_train = pd.read_csv("/Users/hinomaruc/Desktop/notebooks/titanic/titanic_train.csv")

df_eval = pd.read_csv("/Users/hinomaruc/Desktop/notebooks/titanic/titanic_eval.csv")概要確認

# 概要確認

df_train.info()Out[0]

RangeIndex: 891 entries, 0 to 890

Data columns (total 22 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 PassengerId 891 non-null int64

1 Survived 891 non-null int64

2 Pclass 891 non-null int64

3 Name 891 non-null object

4 Sex 891 non-null object

5 Age 891 non-null float64

6 SibSp 891 non-null int64

7 Parch 891 non-null int64

8 Ticket 891 non-null object

9 Fare 891 non-null float64

10 Cabin 204 non-null object

11 Embarked 891 non-null object

12 FamilyCnt 891 non-null int64

13 SameTicketCnt 891 non-null int64

14 Pclass_str_1 891 non-null float64

15 Pclass_str_2 891 non-null float64

16 Pclass_str_3 891 non-null float64

17 Sex_female 891 non-null float64

18 Sex_male 891 non-null float64

19 Embarked_C 891 non-null float64

20 Embarked_Q 891 non-null float64

21 Embarked_S 891 non-null float64

dtypes: float64(10), int64(7), object(5)

memory usage: 153.3+ KB

# 概要確認

df_eval.info()Out[0]

RangeIndex: 418 entries, 0 to 417

Data columns (total 21 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 PassengerId 418 non-null int64

1 Pclass 418 non-null int64

2 Name 418 non-null object

3 Sex 418 non-null object

4 Age 418 non-null float64

5 SibSp 418 non-null int64

6 Parch 418 non-null int64

7 Ticket 418 non-null object

8 Fare 418 non-null float64

9 Cabin 91 non-null object

10 Embarked 418 non-null object

11 Pclass_str_1 418 non-null float64

12 Pclass_str_2 418 non-null float64

13 Pclass_str_3 418 non-null float64

14 Sex_female 418 non-null float64

15 Sex_male 418 non-null float64

16 Embarked_C 418 non-null float64

17 Embarked_Q 418 non-null float64

18 Embarked_S 418 non-null float64

19 FamilyCnt 418 non-null int64

20 SameTicketCnt 418 non-null int64

dtypes: float64(10), int64(6), object(5)

memory usage: 68.7+ KB

# 描画設定

import seaborn as sns

from matplotlib import ticker

import matplotlib.pyplot as plt

sns.set_style("whitegrid")

from matplotlib import rcParams

rcParams['font.family'] = 'Hiragino Sans' # Macの場合

#rcParams['font.family'] = 'Meiryo' # Windowsの場合

#rcParams['font.family'] = 'VL PGothic' # Linuxの場合

rcParams['xtick.labelsize'] = 12 # x軸のラベルのフォントサイズ

rcParams['ytick.labelsize'] = 12 # y軸のラベルのフォントサイズ

rcParams['axes.labelsize'] = 18 # ラベルのフォントとサイズ

rcParams['figure.figsize'] = 18,8 # 画像サイズの変更(inch)モデリング用に学習用データを訓練データとテストデータに分割

# 訓練データとテストデータに分割する。

from sklearn.model_selection import train_test_split

x_train, x_test = train_test_split(df_train, test_size=0.20,random_state=100)

# 説明変数

FEATURE_COLS=[

'Age'

, 'Fare'

, 'SameTicketCnt'

, 'Pclass_str_1'

, 'Pclass_str_3'

, 'Sex_female'

, 'Embarked_Q'

, 'Embarked_S'

]

X_train = x_train[FEATURE_COLS] # 説明変数 (train)

Y_train = x_train["Survived"] # 目的変数 (train)

X_test = x_test[FEATURE_COLS] # 説明変数 (test)

Y_test = x_test["Survived"] # 目的変数 (test)Random Forest

モデル作成

# https://scikit-learn.org/stable/modules/generated/sklearn.ensemble.RandomForestClassifier.html

from sklearn.ensemble import RandomForestClassifier

clf = RandomForestClassifier(random_state=0)clf.fit(X_train,Y_train)Out[0]

RandomForestClassifier(random_state=0)

# Return the mean accuracy on the given data and labels.

print("train",clf.score(X_train,Y_train))

print("test",clf.score(X_test,Y_test))Out[0]

train 0.9859550561797753

test 0.8324022346368715

# モデルパラメータ一覧

clf.get_params()Out[0]

{'bootstrap': True,

'ccp_alpha': 0.0,

'class_weight': None,

'criterion': 'gini',

'max_depth': None,

'max_features': 'auto',

'max_leaf_nodes': None,

'max_samples': None,

'min_impurity_decrease': 0.0,

'min_samples_leaf': 1,

'min_samples_split': 2,

'min_weight_fraction_leaf': 0.0,

'n_estimators': 100,

'n_jobs': None,

'oob_score': False,

'random_state': 0,

'verbose': 0,

'warm_start': False}

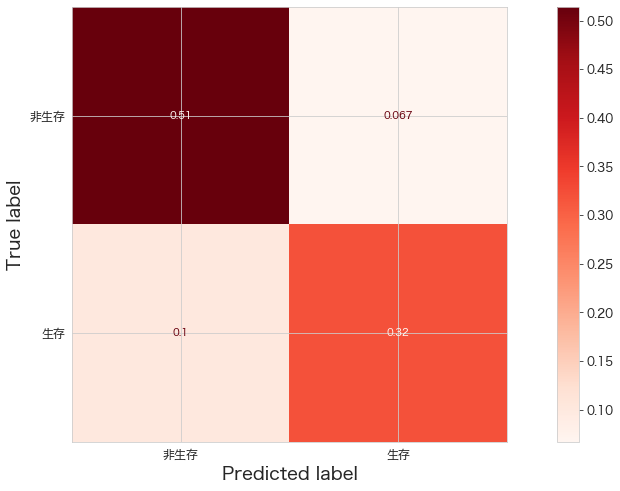

精度確認

# https://scikit-learn.org/stable/modules/generated/sklearn.metrics.ConfusionMatrixDisplay.html

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.metrics import ConfusionMatrixDisplay

from sklearn.metrics import confusion_matrix

print(confusion_matrix(Y_test,clf.predict(X_test)))

ConfusionMatrixDisplay.from_estimator(clf,X_test,Y_test,cmap="Reds",display_labels=["非生存","生存"],normalize="all")

plt.show()Out[0]

[[92 12]

[18 57]]

Kaggleへ予測データをアップロード

df_eval["Survived"] = clf.predict(df_eval[FEATURE_COLS])

df_eval[["PassengerId","Survived"]].to_csv("titanic_submission.csv",index=False)

!/Users/hinomaruc/Desktop/notebooks/my-venv/bin/kaggle competitions submit -c titanic -f titanic_submission.csv -m "model #007. random forest"Out[0]

100%|████████████████████████████████████████| 2.77k/2.77k [00:04<00:00, 603B/s]

Successfully submitted to Titanic - Machine Learning from Disaster

Kaggleでの精度確認の結果

0.73205

まとめ

デフォルトの設定のままでも73.2%の精度が出ました。

次はXgBoostを試します。